社区 发现 产品开发 Down下Home&Kitche...

Down下Home&Kitchen大类1400多小类目top50(6万多条listing)的产品数据,该从哪些维度分析?

发帖2次

被置顶0次

被推荐0次

质量分1星

回帖互动77次

历史交流热度0%

历史交流深度0%

✨

AI 摘要

本内容适合希望快速分析大类目并挖掘热卖小类目的电商卖家与数据分析爱好者查阅。

本文聚焦如何用数据驱动快速筛选热卖小类目、并从分析、监控到工具应用提出实操路径。关键内容亮点如下:

1.

数据获取与成本:

通过服务器爬取大量 listing,成本与并发量需要权衡,外部插件易贵且速度有限。2.

流量与排名分析:

以前50名的 BSR 或综合排名估算类目流量,帮助排除不做的类目。3.

监控与历史趋势:

自建或接入第三方监控,关注跨时段排名变化与历史趋势。4.

数据清洗与实操流程:

使用 Excel/透视表清洗脏数据,结合关键词检索第一页产品进行初步筛选。5.

产品开发与竞争应对:

基于销量导向开发,警惕跟卖与价格战,强调差异化与时效性。6.

工具与自动化:

讨论爬虫、Keepa 等工具、如何自建监控与成本控制。

✨

AI 摘要

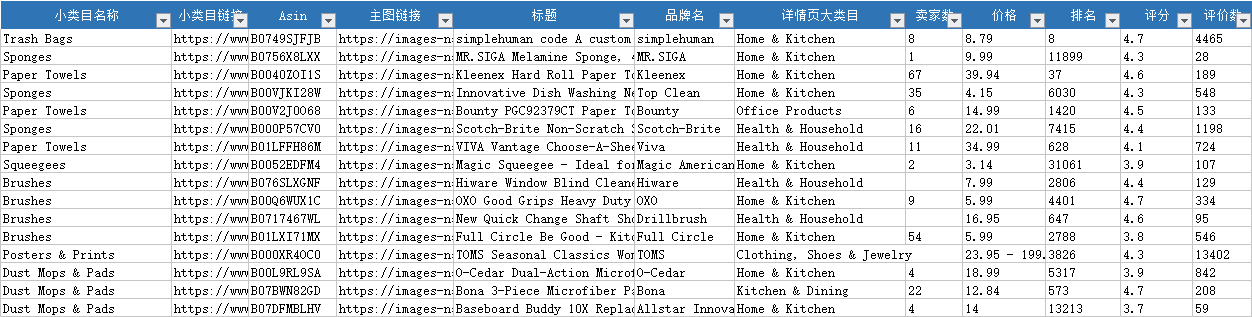

昨晚,心血来潮,想想看下home&kitchen下哪个小类目的产品排名比较诱人,故制作一小爬虫,早上起来,down了一表格,表头如下~~

1. 因为对该类目不熟悉,看不出其所谓然,只能系统浏览下有哪些产品,跟在亚马逊上浏一个样~~

2. 假如拿到这样一个表格,能分析出啥?又能从哪些方面入手,例如去开发一款产品出来?需要结合哪些工具?

-----2018.07.23-----

谢谢莫小波、hclalong2位的回复,还有社区管理员的话题分享。

=============================================================

关于莫小波回复的几点,早上思考了一下,确实给我一些启发,毕竟最初的出发点是以一个小卖家的身份出发,也可以说是如何快速的分析一个大类目,从而筛选出流量不错小类目。

(1)个人获取数据的速度其实与投入成本有关系,一台服务器一晚上也就6万多条listing的数据,但有能力其实可以开多台,例如5-10台一起,速度也相当于X5,但相应的成本也增加。相比外面的ARA及各大插件的数据,优势也像你说的那样,数据真实,比较新,但劣势也比较明显,个人精力有限,能力有限,尤其反爬做得不好,突破不了技术。

(2)爬最小节点第50个产品,根据其排名判断该类目的流量大小,确实对排除一些不做的类目有帮助,当时我是想着用top50的BSR平均值衡量一个类目的流量大小。

(3)对于监控店铺,那样消耗大量的服务器,其实个人认为只监控竞品或同类的店家就可以了,毕竟对一个类目不熟悉,对一个产品不熟悉,也难以驾驭这品类,当然这是狭隘的想法。

(4)关于用关键词去搜第一页的产品,其实前天我也用之前买的home & Kitchen的关键词数据去实践过,也是论坛里有位叫:千叶朋友分享的步骤,是可以关注到一些产品。(只能说技术是辅助手段,最终还是需要人工去核实,还有看灵感)

(5)哈哈,产品的排名肯定是在变的了,那样就得回到你说的第二点,结合其他插件去看历史排名,个人数据不可能监控所以的历史排名。

(解决办法吧:一是自建监控或者利用第三方监控吧,计算其平均排名,目前我有个数据库就是2小时跟踪一排名变化,但能监控的数量肯定有限啦。二是接入别家的token,例如keepa,问题是确实贵~~~)

=============================================================

对于hclalong的回答

(1)根据销量来开发相应的产品,其实排除这一部分的工作是必不可少的,人工尤其重要,这就是人跟机器的区别。

(2)你开发出来的产品,很快就被跟卖,价格减半,这是亚马逊信息差越来越短的原因,以前在亚马逊封闭的数据圈下发现牛的产品会比较慢,开发出一款好的产品有时候可以卖个小半年,现在由于各种技术的介入及数据的分享,只会把产品的红利期缩小,这也是很多中小型卖家烦恼的事情。

最后总结一下:

1、利用这6万多的数据,可以很快筛选出流量好的产品类目,剔除不想做的数目,只需要先用ecxel把脏数据提出,再透视下即可,这也是细分的过程。

到这,其实又产生一个问题:

1、筛选出一个想做的小类目,如何分析这个小类目及开发相应的产品?

2、有什么工具可以去利用?

3、还有自己可以写一些什么工具的提高效率?(例如爬虫)

欢迎大家发表讨论,谢谢。

1. 因为对该类目不熟悉,看不出其所谓然,只能系统浏览下有哪些产品,跟在亚马逊上浏一个样~~

2. 假如拿到这样一个表格,能分析出啥?又能从哪些方面入手,例如去开发一款产品出来?需要结合哪些工具?

-----2018.07.23-----

谢谢莫小波、hclalong2位的回复,还有社区管理员的话题分享。

=============================================================

关于莫小波回复的几点,早上思考了一下,确实给我一些启发,毕竟最初的出发点是以一个小卖家的身份出发,也可以说是如何快速的分析一个大类目,从而筛选出流量不错小类目。

(1)个人获取数据的速度其实与投入成本有关系,一台服务器一晚上也就6万多条listing的数据,但有能力其实可以开多台,例如5-10台一起,速度也相当于X5,但相应的成本也增加。相比外面的ARA及各大插件的数据,优势也像你说的那样,数据真实,比较新,但劣势也比较明显,个人精力有限,能力有限,尤其反爬做得不好,突破不了技术。

(2)爬最小节点第50个产品,根据其排名判断该类目的流量大小,确实对排除一些不做的类目有帮助,当时我是想着用top50的BSR平均值衡量一个类目的流量大小。

(3)对于监控店铺,那样消耗大量的服务器,其实个人认为只监控竞品或同类的店家就可以了,毕竟对一个类目不熟悉,对一个产品不熟悉,也难以驾驭这品类,当然这是狭隘的想法。

(4)关于用关键词去搜第一页的产品,其实前天我也用之前买的home & Kitchen的关键词数据去实践过,也是论坛里有位叫:千叶朋友分享的步骤,是可以关注到一些产品。(只能说技术是辅助手段,最终还是需要人工去核实,还有看灵感)

(5)哈哈,产品的排名肯定是在变的了,那样就得回到你说的第二点,结合其他插件去看历史排名,个人数据不可能监控所以的历史排名。

(解决办法吧:一是自建监控或者利用第三方监控吧,计算其平均排名,目前我有个数据库就是2小时跟踪一排名变化,但能监控的数量肯定有限啦。二是接入别家的token,例如keepa,问题是确实贵~~~)

=============================================================

对于hclalong的回答

(1)根据销量来开发相应的产品,其实排除这一部分的工作是必不可少的,人工尤其重要,这就是人跟机器的区别。

(2)你开发出来的产品,很快就被跟卖,价格减半,这是亚马逊信息差越来越短的原因,以前在亚马逊封闭的数据圈下发现牛的产品会比较慢,开发出一款好的产品有时候可以卖个小半年,现在由于各种技术的介入及数据的分享,只会把产品的红利期缩小,这也是很多中小型卖家烦恼的事情。

最后总结一下:

1、利用这6万多的数据,可以很快筛选出流量好的产品类目,剔除不想做的数目,只需要先用ecxel把脏数据提出,再透视下即可,这也是细分的过程。

到这,其实又产生一个问题:

1、筛选出一个想做的小类目,如何分析这个小类目及开发相应的产品?

2、有什么工具可以去利用?

3、还有自己可以写一些什么工具的提高效率?(例如爬虫)

欢迎大家发表讨论,谢谢。

倒计时:

倒计时:

19 个回复

吉诺比利 - 吉诺比利

赞同来自: 浪里个浪啊啊 、 kuayue72 、 小太洋 、 哈哈先生 、 Nonoo 、 Zzzzz 、 Amazonlover 、 johnlinchen 、 慕白111 、 TechTerry 、 超级无敌赞 、 YINYING 、 包子馅儿坏了 、 Joycelele 更多 »

有了数据之后,就可以分红海和蓝海的选品了,结合关键词搜索工具,关键词趋势工具,js为代表的国内外选品软件进行一一查验,考虑因素主要有供应链,利润,运输,拍照难度,尺寸,是否侵权,是否要认证,是否高关税,是否有季节性,关键词搜索量趋势,市场竞争,推广难度,产品更新速度,产品的市场认可的(评价)....此处打字速度高于大脑思考速度,欢迎大家拍砖补充。

然后说一下我以前自己爬数据的时候是怎么干的,我只爬了一个星期,后来公司不支持就放弃了,我只能说说我对于爬虫这个工具的一些使用心得,有些想法因为一些原因,有个人也有公司的,并没有完全实现。

首先声明,某些培训机构里面所谓的“爬虫大数据选品什么”真的笑笑就好,我也不想多说什么,都是一些很基础的用爬虫替代重复性劳动的小case。

1.根据BTG把每个节点下第50名对应的排名提出来,例如('678540011'节点下第50名对应的是Home&Kitchen 18,055) 这样做的目的就是判断每个根节点(最细的那个类目)值不值得做,意思就是如果'678540011'这个小类目的第50名在大类的排名都非常靠后的话,那这个类目就是比较冷门的类目,出单量不是很多可以视情况放弃,之后筛选出排名还OK的节点,用另外一个方法爬取bestsellers rank 100 之外的产品(但是更加费时,爬虫效率会更加低)

总结:这样你可以排除掉一些不做的类目,同时对大类目下整个单量的分布情况有个大概的了解。

2.当初想到自己用爬虫爬数据是因为公司走的铺货的路线,把数据爬下来,根据review,排名和价格可以筛选出一箩筐“竞争不是很大”的产品,顺便记录该产品对应店铺的merchant token,大概几百个店铺吧,然后定期监测这些店铺的上新情况(相当于几百个不认识的产品开发在帮你干活,好吧这句话是我YY的)。

3.比如说你想做iPhone x 手机壳,你完全可以去每个最小类目用关键词来搜,只抓第一页的数据,这样所有卖得好的和刚卖起来的手机壳你都可以掌握在自己手里。

3.然后,那么大的数据量只看你一晚上爬下来的数据是不够的,产品的排名会一直在变(那你该怎么办?)我也不知道怎么办,如果你知道请告诉我。

......

随意分享的,时间不够了,要去健身房撸铁了,回头重新整理一下语言和逻辑,视情况决定要不要重新编辑。