社区 发现 Amazon 【喂饭级讲解】亚马逊产品关键词词库标注思...

【喂饭级讲解】亚马逊产品关键词词库标注思路,深度细节披露+工具提效

hello,大家好,这是Andy的第11篇文章,感谢阅读,前排求个关注

之前分享的内容主要是AI落跨境电商应用,可以看我主页了解更多往期内容

最近关注到一个新的工具,让我觉得非常欣喜,因为起码可以对我的一项运营工作提效30%以上。

这个工具就是 -- 筛查相关性(关键词),我已经进行了深度尝试,借此机会跟大家分享一下我对关键词的理解。

一、 关键词分类

关键词的本质其实就是消费者的需求描述。

中高级运营应该会明白构建产品关键词库里面有一项工作极其费时且枯燥,就是对关键词进行标注,其中涉及到三项类型标注

- 流量分类(定量):高流量词、中流量词、低流量词

- 词性分类(定性):类目词、产品词、属性词、功能词、场景词、参数词、衍生词等各种词性

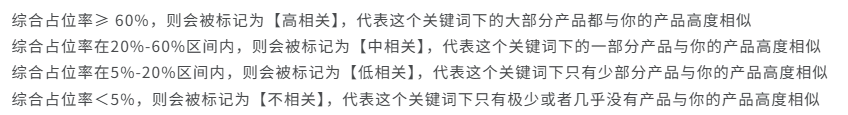

- 相关度分析(定性):核心标准是参照你的产品,该关键词搜索结果top20产品与你的产品相关度

1.流量分类:

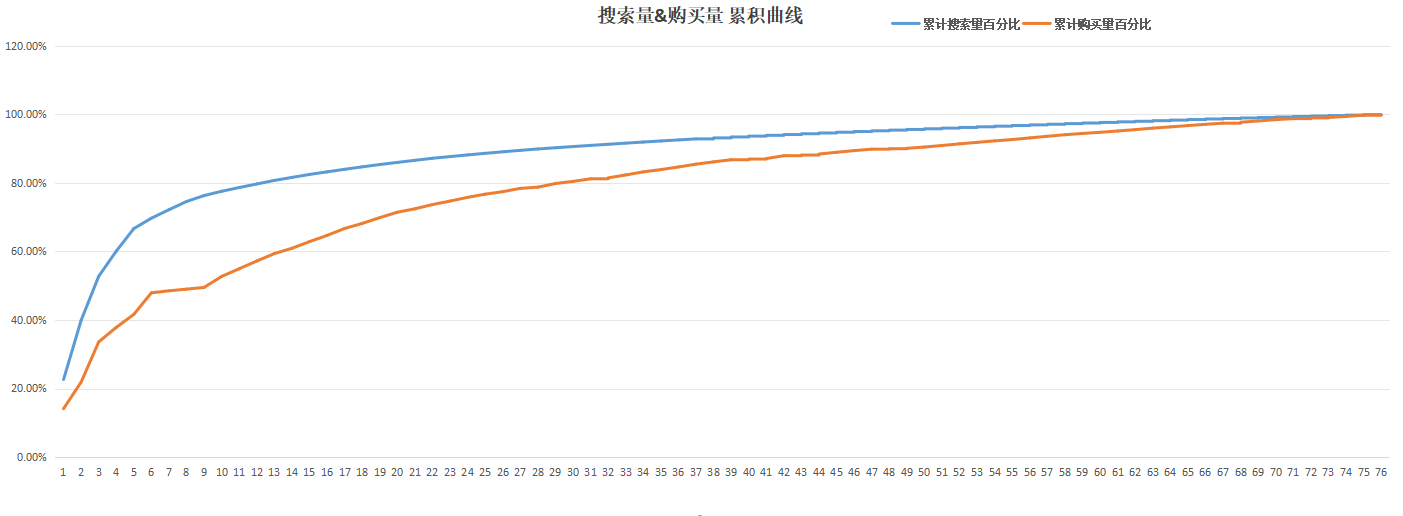

首先说流量分类,这个非常简单,但是不同类目你对流量的高中低量级定义也会有差异,例如不太可能拿portable power station 和garlic press来进行流量对比,因为两个市场本身就不是同一个量级的,所以我们应该通过设立 百分位+累积流量占比 两个参数进行划分:

- 百分比:[list][*]top 20%关键词为高流量词,即头部关键词,而且因为“二八定律”以及头部聚集效应,20%的关键词可能对流量的占比会超过70%,不同类目有差异(需求描述丰富度)

- top 20%-60%为中流量词,即中部关键词,新品上架这块才是我们最大的机会,逐步占领腰部流量词,从而达到农村包围城市的效果,上架就打大词会极其难受(转化率和基础权重积累都较差)

- top 60%-100%为低流量词,即尾部关键词,如果一个市场是“需求长尾市场”,即使是尾部关键词一样会有不错的流量份额,我们需要完善们的关键词架构,这部分关键词就不能落下

[/*]

[*]累积流量占比:

- 纵轴:流量绝对值+流量份额

- 横轴:关键词排位

看累计曲线,我比较关注80%的站位情况,可以看到搜索量在前13位的关键词已经占据整体流量的80%,但是购买量曲线相对“长尾”,说明头部的一些关键词并未能充分体现消费者的真实需求,说明长尾需求还是有机会的。[/*]

[*]关键词特征:[/*]

[/list]

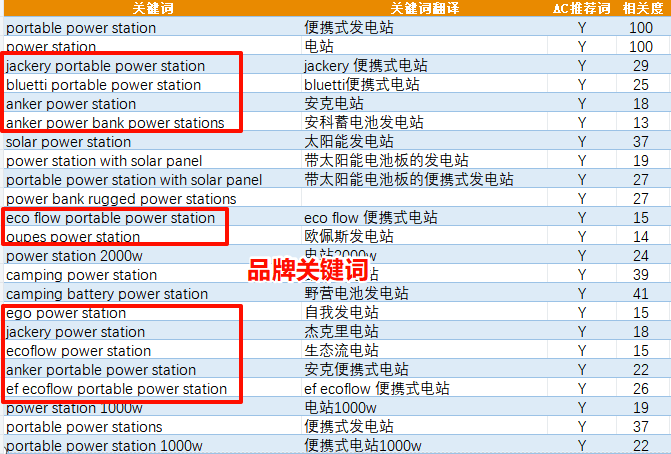

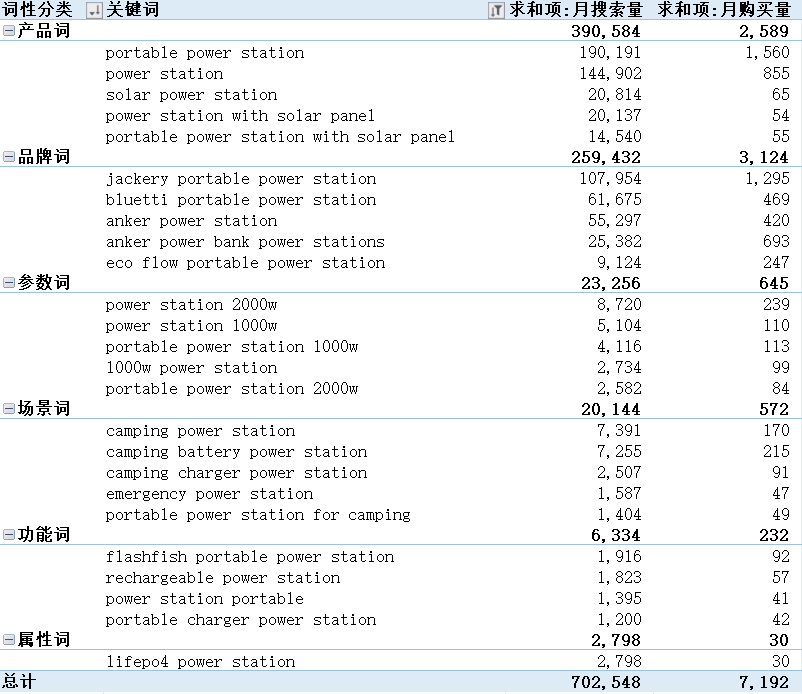

再来看一下头部关键词的特征,从词性分类来看,可以看到头部的关键词有非常大的比例都是品牌关键词,说明头部品牌已经建立了良好的品牌心智,客户对品牌的忠诚度较高。

结合上面曲线+关键词特征来看,这种情况其实是不太有利于新品牌进入的,头部流量被品牌关键词把持,你不打就没有流量,你要打这个关键词就得拼产品竞争力(非常艰难),如果不是资本雄厚的公司,通常在红海市场中挖掘长尾需求,与头部品牌各方面均衡走差异化路线,集中精力和资源将某一卖点拉升到类目top5%以内(长板效应),先拿捏一部分长尾需求客户群体

2.词性分类

接下来就是我们的重点,进行词性分类,通常我们通过各种方式收集完关键词之后,常规的处理流程:

1.统一关键词表格字段(不建议不同软件的关键词表格进行聚合,因为不同软件的拟合算法不一样,流量维度会有较大差异)

2.梳理好关键词总表之后我们就要开始对词性进行分类(上面举例的词性分类)

3.分类之后进行数据透视,分析不同类型关键词的流量特征、占比情况

二、常规方法(表格手动标注)

先说一下常规的关键词分类(相关度筛查)方法,获取关键词列表通常有以下方法:

这里我们以Portable Power Station为例进行示例

1.关键词词库获取

1.关键词拓展:通过卖家精灵的关键词拓展,可以使用词根快速拓展关键词词库

2.ASIN关键词反查:通过卖家精灵可以进行ASIN反查流量词,并且可以看到ASIN在关键词下的流量占比情况

3.后台ABA数据:ABA关键词数据一样可以通过关键词 / ASIN的形式进行拓展

通过在精灵的关键词挖掘功能,也可以方便快速展示

2.关键词分类

根据上文所述,关键词词库拿到手之后还需要进行二次标注,我一般添加最重要的三个核心字段

词性分类 | 流量层级 | 相关度

a.词性分类当前标注我觉得最有效的方式还是手动

b.流量层级建议按照百分位进行划分,因为不同类目差异较大。

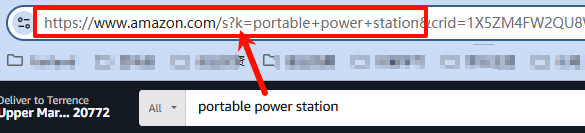

c.剩下最后一个字段相关度相关度标注,这个之前是通过表格中构建关键词搜索结果链接进行前台检索,查看该关键词的整体搜索结果与自己的产品相关度情况。具体构建情况如图所示

三、创新方法(编程/ AI/ 软件)

可以看到常规标注费时费力,你得根据关键词意思揣测关键词对你产品的相关度,如果要做的更加到位,还需要检索关键词在前台的真实搜索结果是否与产品核心关联,就这一部分的工作会耗费大量的时间,而且这种工作较为机械重复(丢给助理、实习生进行标注)

在入行之初就发现了这里的执行痛点,后面一直在探索是否有更加高效的执行办法(自动化?),探索了下面的路径:

1.Python NLP模型标注

主要有两种思路:

1.通过传统的自然语言处理(NLP)库,如(NLTK、spaCy)等标注语法词性,效果较差

2.通过规则匹配与自定义词库实现业务层面的词性分类(如品牌词、参数词等),这个效果相对较好,只要梳理好关键词的词根类型就可以进行快速标注,这里贴一个示例代码

import pandas as pd2.AGI大模型标注(WPS多维表调用DeepSeekR1)

# 假设数据存于 Excel,读取到 DataFrame

df = pd.read_excel('your_file.xlsx')

# 定义各类词库(需根据实际标注数据完善)

brand_words = ['jackery', 'bluetti', 'anker', 'ecoflow', 'dji', 'browney', 'grecell', 'alwei']

parameter_words = ['2000w', '1000w'] # 示例参数词

scene_words = ['camping'] # 示例场景词

# 定义标注函数

def classify_keyword(keyword):

keyword_lower = keyword.lower()

# 优先匹配品牌词

for brand in brand_words:

if brand in keyword_lower:

return '品牌词'

# 匹配参数词

if any(p in keyword_lower for p in parameter_words):

return '参数词'

# 匹配场景词

if any(s in keyword_lower for s in scene_words):

return '场景词'

# 其他默认(可根据需求扩展)

if 'power station' in keyword_lower:

return '产品词'

return '未知'

# 应用函数生成标注结果

df['词性分类'] = df['关键词'].apply(classify_keyword)

# 保存结果(可选)

df.to_excel('annotated_file.xlsx', index=False)

这里暂且不表,但是核心逻辑就是通过人工智能模型(例如DeepSeekR1)进行词性标注,最近在探索多维表的应用,感兴趣的可以先给Andy点个关注,后续会分享使用多维表进行项目管理等应用。

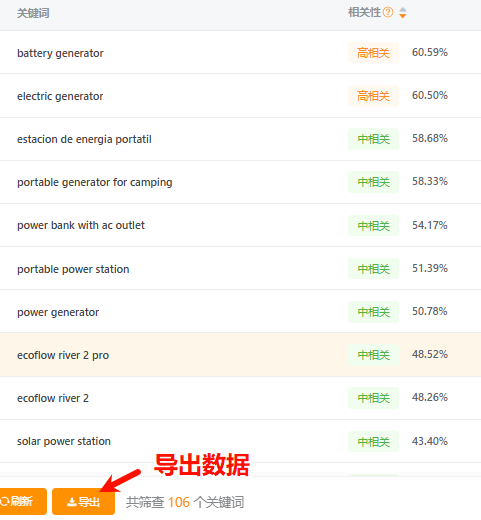

3.软件标注(卖家精灵)

相关度评估不再需要再一个个去前台进行检索,只需要输入核心竞对ASIN,再输入待检索关键词,即可快速通过软件进行相关度标注

即可得到相关度标注结果

导出之后通过VLOOKUP函数,匹配到关键词相关度字段

- 对于【高相关】关键词的投放策略:中后期主力投放关键词,通常会分配70%以上广告预算,通过精准/ 加价等积极行为拉升关键词排位

- 对于【中相关】关键词的投放策略:可以分配一定预算,测试在这些关键词下的转化、ROI数据,再评估是否需要追加预算,加大投入

- 对于【低相关】关键词的投放策略:小部分预算测试投放组,主要目的是通过低价蹭流丰富流量结构,核心指标为cpc/ acos,偏向与捡漏打法

四、关键词分类应用

1.关键词分析

完成关键词标注分类之后,可以根据词性分类进行透视,本质上就是某一类需求的量化情况,可以洞察到消费者对哪些层面的需求更加强烈,核心关注的产品属性是什么?

可以看到这里的结构性已经非常强了,是不是就立马想到广告架构了?

产品型号 -- 广告组合

词性分类 -- 广告活动

投放方式 -- 广告组合

层层对应,严丝合缝,良好的广告架构规划对于后续的广告报表分析也是非常有利的。

结合领星的超级结构,可以快速创建广告架构(吐槽一句,后台的广告批量报表是真的难用)

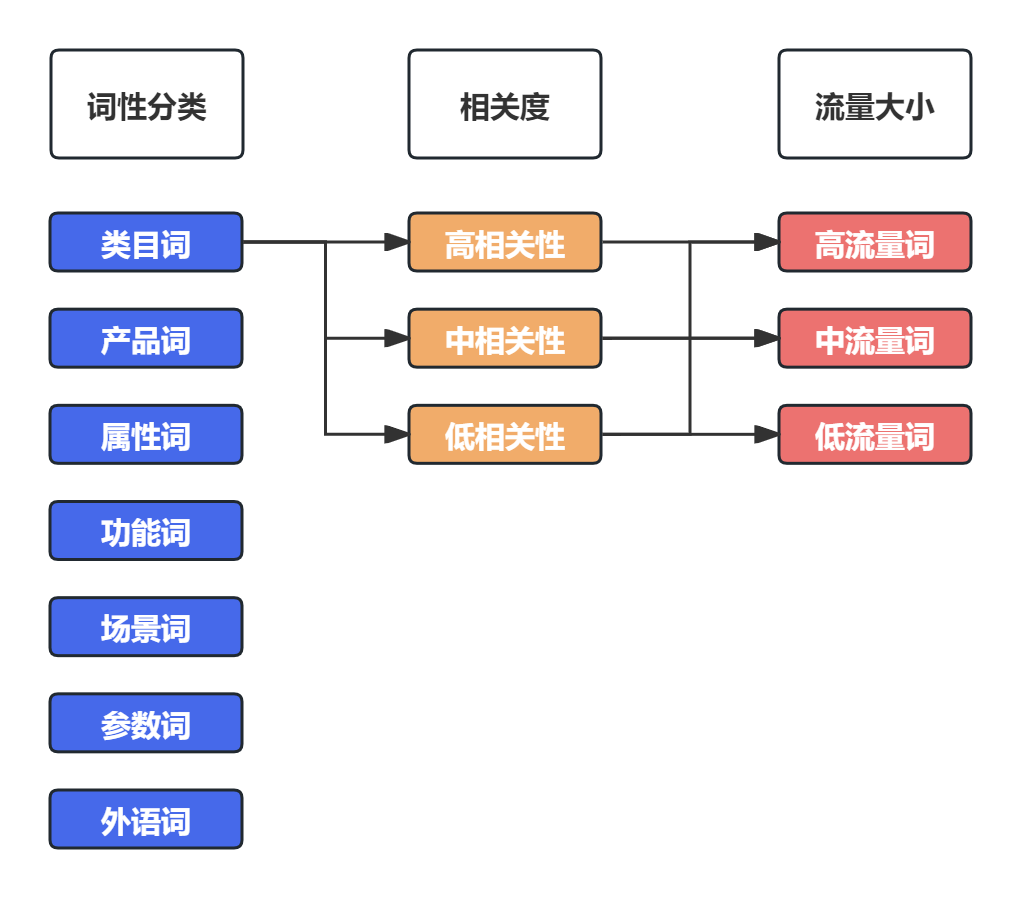

2.交叉分析

可以通过 词性分类 | 流量大小 | 相关度 进行交叉分析,例如我要件一个新广告活动,需要针高容量段(1000Wh以上)的流量大词做投放,活动的主要目的是达成转化(高相关度),那么我们就可以使用下面的筛选条件进行筛选:

参数词(电量) X 高流量词 X 高相关度

通过三维筛选即可快速筛选出满足我们需求的关键词列表,添加到广告活动投放。

从上面的架构就可以引申到高中数学一个非常常用的知识点:组合

通过词性分类之后,所有可能得筛选类型数量:C(1, m)x C(1,3)x C(1,3)

m为词性分类的类型数量

======================================================================

如果对上面关键词分析有疑问的或者提升建议的,可以直接评论区交流。

每一个回复都会认真看且细致回复,感谢阅读~

倒计时:

倒计时:

9 个回复

匿名用户

赞同来自:

top 20%-60%为中流量词,即中部关键词,新品上架这块才是我们最大的机会,逐步占领腰部流量词,从而达到农村包围城市的效果,上架就打大词会极其难受(转化率和基础权重积累都较差)

top 60%-100%为低流量词,即尾部关键词,如果一个市场是“需求长尾市场”,即使是尾部关键词一样会有不错的流量份额,我们需要完善们的关键词架构,这部分关键词就不能落下”

请问这个20%是指ABA排名吗